Administration et supervision

Administration d’Azure Data Factory

L’administration d’Azure Data Factory consiste principalement en la gestion des droits, de la configuration des services liés, des déclencheurs ainsi que des Integration Runtimes.

Azure Data Factory est résolument orienté DevOps (comprendre que le développeur automatise au maximum l’exploitation de la solution via intégration et livraison continues). Cela implique que les chaînes de connexions, la planification et les Integration Runtimes sont parties intégrantes du projet de développement.

1. Droits

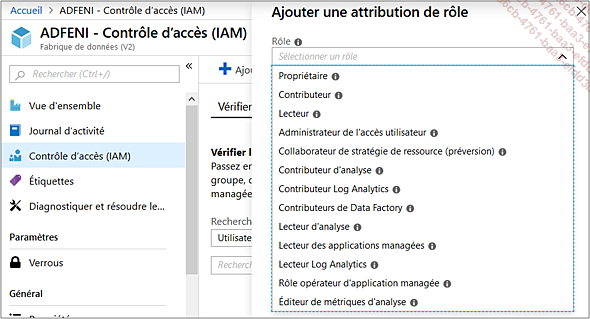

La gestion des droits dans Azure Data Factory est faite via le portail Azure dans la section Contrôle d’accès (IAM).

La liste des rôles disponibles est la suivante :

-

Propriétaire : contrôle total sur la ressource Azure Data Factory, y compris la gestion des droits.

-

Contributeur : contrôle total, à l’exception de la gestion des droits.

-

Lecteur : permet d’afficher les objets Azure Data Factory tels que les pipelines, les activités, les déclencheurs, mais ne permet pas la modification de ceux-ci.

-

Administrateur de l’accès utilisateur : permet uniquement la gestion des droits.

-

Collaborateur de stratégie de ressource : autorise l’utilisateur à créer et gérer des attributions de stratégies (Policies), ainsi que de créer des tickets de support.

-

Contributeur d’analyse : donne le droit de lire les informations de surveillance, ainsi que de créer ou modifier des alertes.

-

Contributeur Log Analytics : peut lire et modifier toutes les données de surveillance.

-

Contributeurs de Data Factory : permet de faire des modifications sur une Azure Data Factory intégrée à Git, mais ne permet pas de publier celle-ci.

-

Lecteur d’analyse : peut lire toutes les données de supervision (métriques, journaux d’activité, etc.).

-

Lecteur des applications managées : permet...

Supervision Azure Data Factory

Azure Data Factory permet une supervision gérée nativement. Celle-ci est accessible depuis le portail Azure Data Factory adf.azure.com. Elle peut aussi être consolidée aux autres journaux d’Azure grâce à Azure Monitor, ce qui permet d’augmenter la rétention des journaux et de les requêter directement depuis PowerBI. Enfin, les Integration Runtimes disposent aussi de leurs propres mécanismes de supervision.

1. Portail Azure

Le portail Azure permet une supervision des pipelines, déclencheurs et Integration Runtimes. Il s’agit d’une interface graphique facile de prise en main, qui permet d’identifier rapidement l’état des pipelines et de récupérer les erreurs de ceux-ci.

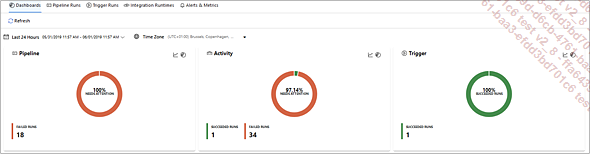

a. Tableau de bord

L’onglet tableau de bord permet d’avoir un premier niveau d’information sur l’état général des exécutions de pipelines, activités et déclencheurs sur la période sélectionnée.

Les graphiques sont interactifs. Ainsi un clic sur la tranche des pipelines en échec dirige directement vers l’onglet Pipeline Runs filtré sur ceux-ci.

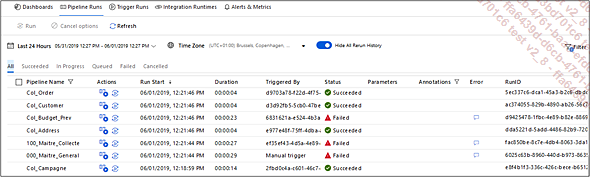

b. Exécution de pipeline

L’onglet de suivi d’exécution de pipeline (Pipeline Runs) permet d’avoir une vue détaillée sur les exécutions. Il est décomposé de la façon suivante :

Les filtres de dates sont disponibles sur le haut de l’écran, ceux-ci permettent de filtrer les exécutions sur une période donnée. L’option Hide All Rerun History permet de choisir d’afficher uniquement la dernière exécution lorsqu’un pipeline a été réexécuté.

La liste des exécutions est ensuite affichée avec la possibilité de filtrer celles-ci en fonction de leur statut : Succès (Succeeded), En cours (In Progress), En attente (Queued), Échec (Failed), Annulé (Cancelled).

Les informations affichées sont les suivantes :

-

Pipeline Name : le nom du pipeline exécuté, cette colonne peut être filtrée en sélectionnant le sablier à côté du nom de la colonne.

-

Run Start : la date de début d’exécution du pipeline, celle-ci...

Gestion des coûts

Les architectures dans le nuage (Cloud) sont par définition élastiques. S’il s’agit d’une force pour le développeur, cela rend difficile l’estimation des coûts qui varient en fonction de l’utilisation faite de l’outil. Toutefois, il est possible d’obtenir une estimation en comprenant ce qui est facturé lors de l’utilisation d’Azure Data Factory.

1. Orchestration

Le premier élément facturé est l’orchestration, cela comprend tout déclenchement de Pipeline (à chaque fois que l’on obtient un RunId) qui peut être provoqué par un déclencheur, le lancement d’une activité ou une exécution en débogage.

L’orchestration est facturée 0,844 € pour 1000 exécutions sur un Integration Runtimes Azure et 1,265 € pour les exécutions sur un Integration Runtimes auto-hébergé.

Exemple : un pipeline déclenché toutes les 15 minutes coûte en orchestration 0,844/1000*4*24 = 0,081 € par jour sur un Integration Runtimes Azure. 1,265/1000*4*24 = 0,121 € par jour sur un Integration Runtimes Auto-Hébergé.

2. Exécution

Les choses se compliquent. La facturation à l’exécution n’est pas la même pour les activités de déplacement de données...

Editions ENI Livres | Vidéos | e-Formations

Editions ENI Livres | Vidéos | e-Formations